2022年9月7日,在悉尼举办的国际数据库与数据管理顶级会议VLDB 2022(International Conference on Very Large Databases,简称VLDB)上,北京大学计算机学院崔斌教授课题组的论文“基于分布式缓存的大规模可扩展嵌入模型训练框架(HET: Scaling out Huge Embedding Model Training via Cache-enabled Distributed Framework)”获得大会可扩展数据科学最佳论文奖(Best Scalable Data Science Paper)。

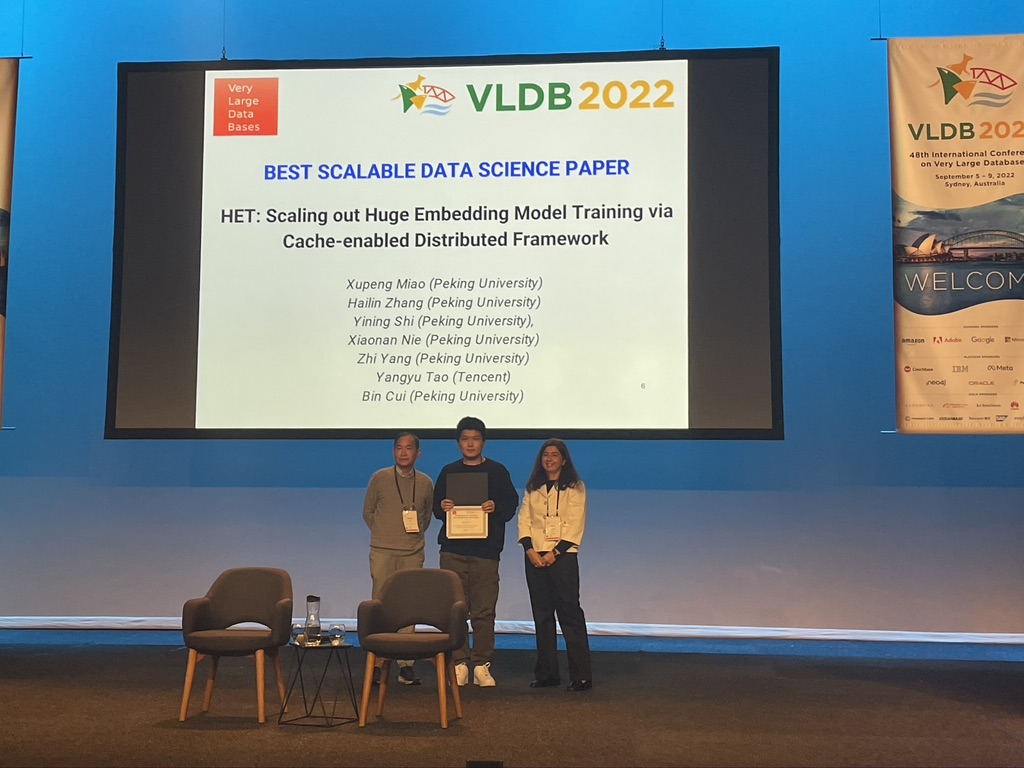

VLDB大会颁奖典礼

VLDB是数据库与数据管理领域的三个顶级会议之一,自1975年开办至今,VLDB会议已经成功举办了48届,被中国计算机学会列为A类推荐国际学术会议。本次VLDB 2022会议的研究论文投稿分为Regular Research Papers(常规研究)、Scalable Data Science Papers (可扩展数据科学)、Experiment, Analysis & Benchmark Papers(实验、分析和基准)和Vision Papers四个类别,共收录了198篇研究论文,评选出Regular Research、Experiment, Analysis and Benchmark、Scalable Data Science三篇最佳研究论文奖。获奖论文HET在众多论文中脱颖而出,并在大会开幕当日进行首个论文报告。

VLDB大会论文报告现场

稀疏嵌入大模型是目前参数量可以达到万亿规模的重要深度学习模型类型之一,被广泛应用于搜索广告推荐、图表示学习等场景,学习数据中的高维离散稀疏特征表达。现有分布式训练系统大部分采用参数服务器架构,面临着严峻的通信瓶颈。为了解决该问题,获奖论文提出了一套基于嵌入缓存的新一代稀疏大模型训练架构HET。具体来说,论文利用稀疏大模型对嵌入参数的非均匀访问特性,设计了一种支持嵌入参数缓存的混合通信架构;同时,为了解决分布式缓存的一致性问题,设计了一种细粒度嵌入向量时钟的有限异步协议。实验表明,HET可以降低88%的通信代价,训练速度可以提升20倍以上,支持万亿规模稀疏大模型的高效分布式训练。

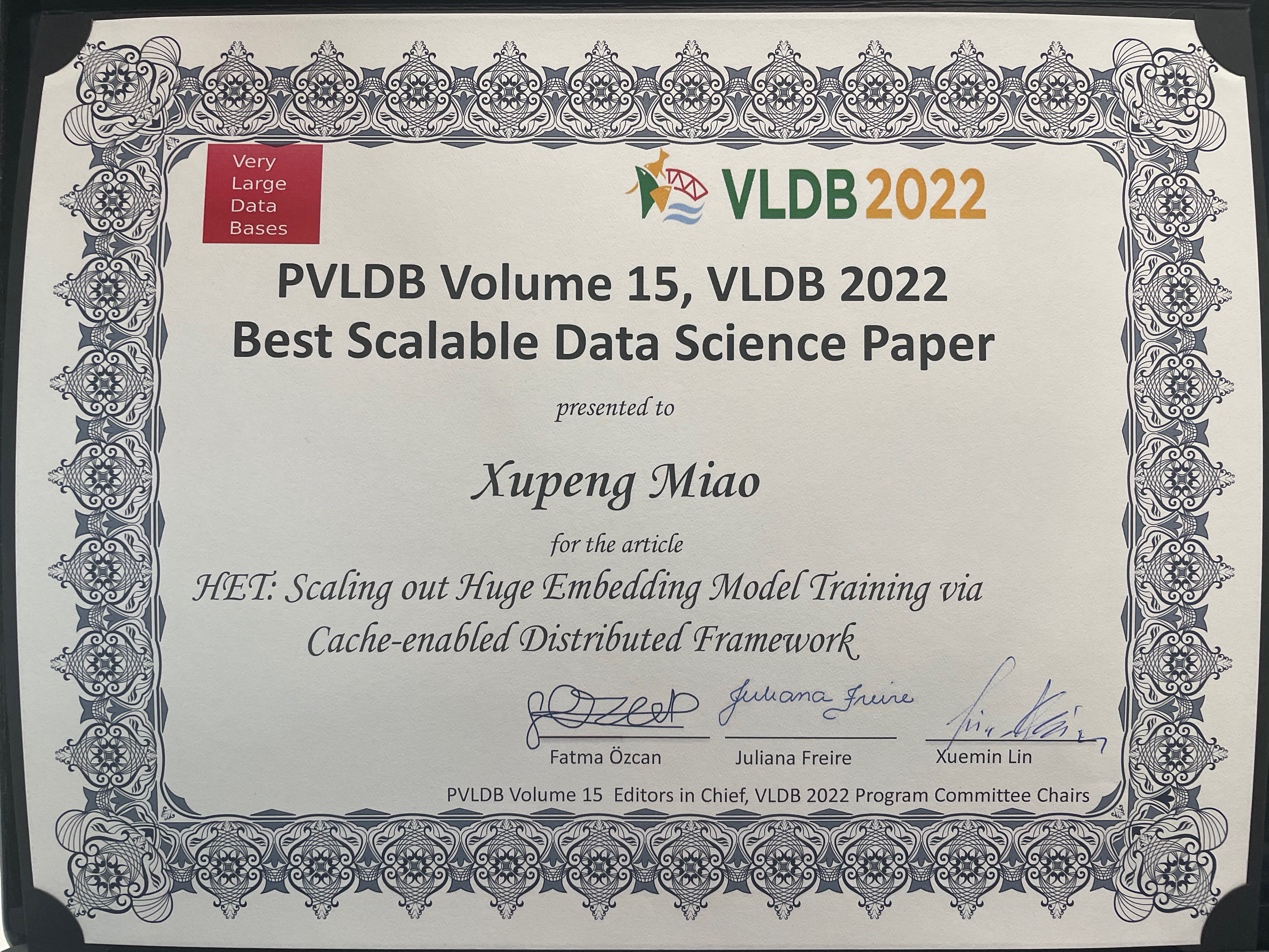

获奖证书

本文第一作者为计算机学院2017级博士生苗旭鹏,通讯作者为崔斌教授和杨智副研究员,论文作者还包括2020级博士生张海林,2021级硕士生石屹宁,2019级博士生聂小楠,以及来自腾讯机器学习平台部的陶阳宇。

目前,论文所提出的HET框架已经集成到了课题组自研的分布式深度学习系统河图(Hetu),并在GitHub开源:https://github.com/PKU-DAIR/Hetu。河图主要应用在云计算以及人工智能场景,可以提高深度学习模型训练效率,降低深度学习模型开发成本,推动深度学技术创新以及 AI 产业的快速落地。河图作为唯一高校代表成果入选了2021年AI中国年度十大开源事件,在中国计算机学会BDCI大赛等多个赛事取得最高奖,并在包括腾讯等多个公司的实际业务场景得到应用,取得显著的经济效益。

崔斌教授VLDB大会特邀报告

近几年来,崔斌教授课题组河图团队围绕大规模机器学习以及深度学习系统优化,展开了一系列系统性研究工作,相关成果已陆续发表于SIGMOD、VLDB、ICDE、ICML、KDD、TKDE等国际顶级会议和期刊,取得了学术界和工业界的广泛关注。此次获奖,表明北京大学在可扩展数据科学与机器学习系统领域的研究水平持续处于国际前沿水平。另外,崔斌教授也在此次VLDB大会上进行了题为“面向大模型的分布式机器学习(Distributed Machine Learning for Big Models)”的特邀报告,介绍了实验室在大模型训练方面的系统性进展,受到了与会同行的一致好评。

数据科学与工程所崔斌教授团队获得数据库国际会议VLDB最佳论文奖

数据科学与工程所崔斌教授团队获得数据库国际会议VLDB最佳论文奖